Une nouvelle frontière pour la finance ?

Les secteurs bancaire et financier ont été parmi les premiers à adopter les technologies d’intelligence artificielle (IA) et d’apprentissage automatique (ML). Ces innovations nous ont donné la capacité de développer des modèles alternatifs et stimulants et d’améliorer les modèles et analyses existants rapidement et efficacement dans un large éventail de domaines fonctionnels, de la gestion des risques de crédit et de marché à la connaissance des clients (KYC), en passant par la lutte contre le blanchiment d’argent (AML). et la détection des fraudes pour la gestion de portefeuille, la construction de portefeuille et bien plus encore.

L’apprentissage automatique a automatisé une grande partie du processus de développement de modèles, en compressant et en simplifiant le cycle de développement de modèles. De plus, les modèles basés sur l’apprentissage automatique ont été aussi performants, voire meilleurs, que leurs homologues traditionnels.

Aujourd’hui, ChatGPT et les grands modèles de langage (LLM) représentent plus généralement la prochaine évolution de la technologie IA/ML. Et cela a une série d’implications.

L’intérêt du secteur financier pour les LLM n’est pas surprenant étant donné leur vaste pouvoir et leur large applicabilité. ChatGPT peut apparemment « comprendre » le langage humain et fournir des réponses cohérentes aux questions sur n’importe quel sujet.

Ses cas d’utilisation sont pratiquement illimités. Un analyste des risques ou un agent de banque peut demander d’évaluer le score de risque de l’emprunteur et de faire une recommandation sur une demande de prêt. Un gestionnaire de risques ou un cadre supérieur peut l’utiliser pour résumer les positions actuelles en matière de capital et de liquidité d’une banque afin de répondre aux préoccupations des investisseurs ou des autorités réglementaires. Un développeur de recherche et de quantification peut lui demander de développer un code Python qui estime les paramètres d’un modèle à l’aide d’une fonction d’optimisation donnée. Un responsable de la conformité ou un responsable juridique peut demander à examiner une loi, un règlement ou un contrat pour déterminer son applicabilité.

Mais il existe des limites et des risques réels associés aux LLM. Malgré l’enthousiasme initial et l’adoption rapide, les experts ont tiré plusieurs alarmes. Apple, Amazon, Accenture, JPMorgan Chase et Deutsche Bank, entre autres sociétés, ont interdit ChatGPT sur le lieu de travail, et certains districts scolaires locaux ont interdit son utilisation en classe, invoquant les risques encourus et les abus potentiels.. Mais avant de pouvoir trouver une solution à ces problèmes, nous devons d’abord comprendre le fonctionnement de ces technologies.

ChatGPT et LLM : comment ça marche ?

Certes, les détails techniques précis du réseau neuronal ChatGPT et de sa formation dépassent le cadre de cet article et, en fait, ma compréhension. Cependant, certaines choses sont claires : les LLM ne sont pas comprendre des mots ou des phrases comme nous le faisons, les humains. Pour nous, les humains, les mots s’emboîtent de deux manières distinctes.

Syntaxe

D’une part, nous examinons une série de mots du point de vue de la syntaxe, en essayant de les comprendre en nous basant sur les règles de construction applicables à une langue particulière. Après tout, la langue est bien plus qu’un fouillis de mots. Il existe des règles grammaticales précises et sans ambiguïté sur la manière dont les mots s’assemblent pour transmettre leur sens.

Les LLM peuvent deviner la structure syntaxique d’une langue à partir des régularités et des modèles qu’ils reconnaissent à partir de tout le texte de leurs données de formation. Ceci est similaire à un anglophone natif qui n’a peut-être jamais étudié l’anglais formel à l’école mais qui sait quels types de mots sont susceptibles de suivre dans une série compte tenu du contexte et de ses propres expériences passées, même si sa connaissance de la grammaire peut être loin d’être la même. parfait. Les LLM sont similaires. Parce qu’ils n’ont pas de compréhension algorithmique des règles syntaxiques, ils ne remarqueront peut-être pas certains cas grammaticaux formellement corrects, mais ils n’auront aucun problème à communiquer.

Sémantique

« Un poisson maléfique orbite joyeusement autour des jeux électroniques. »

La syntaxe fournit un niveau de contrainte sur le langage, mais la sémantique fournit une contrainte encore plus complexe et plus profonde. Non seulement les mots doivent s’emboîter selon les règles de la syntaxe, mais ils doivent aussi avoir un sens. Et pour avoir du sens, ils doivent communiquer du sens. La phrase ci-dessus est grammaticalement et syntaxiquement correcte, mais si nous traitons les mots tels qu’ils sont définis, cela n’a aucun sens.

La sémantique présuppose un modèle du monde dans lequel la logique, les lois naturelles, les perceptions humaines et les observations empiriques jouent un rôle important. Les humains ont une connaissance presque innée de ce modèle – si innée que nous l’appelons simplement « bon sens » – et l’appliquent inconsciemment dans notre discours quotidien. ChatGPT-3, avec ses 175 milliards de paramètres et ses 60 à 80 milliards de neurones, comparés aux quelque 100 milliards de neurones et aux 100 000 milliards de connexions synaptiques du cerveau humain, aurait-il pu implicitement découvrir le « Modèle du Langage » ou dans certains déchiffrer la loi de la sémantique ? ? avec lesquels les humains créent des phrases significatives ? Pas exactement.

ChatGPT est un moteur de statistiques géant formé sur du texte humain. Il n’existe aucune logique sémantique généralisée formelle ou structure informatique qui le pilote. Par conséquent, ChatGPT n’a pas toujours de sens. Il produit simplement ce qui « sonne bien » sur la base de ce qui « sonne » sur la base de ses données d’entraînement. Il extrait des fils cohérents de textes de la sagesse statistique conventionnelle accumulée dans son réseau neuronal.

Clé de ChatGPT : intégration et attention

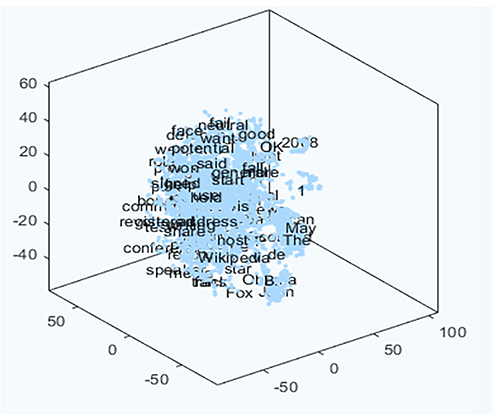

ChatGPT est un réseau neuronal ; traite les nombres et non les mots. Il transforme des mots ou des fragments de mots, environ 50 000 au total, en valeurs numériques appelées « jetons » et les intègre dans leur espace de signification, essentiellement des groupes de mots, pour montrer les relations entre les mots. Ce qui suit est une visualisation simple de l’intégration en trois dimensions.

Espace de signification ChatGPT tridimensionnel

Bien entendu, les mots ont de nombreuses significations et associations contextuelles différentes. Dans ChatGPT-3, ce que nous voyons dans les trois dimensions ci-dessus est un vecteur dans le 12 228 dimensions nécessaires pour capturer toutes les nuances complexes des mots et leurs relations les uns avec les autres.

En plus des vecteurs intégrés, les têtes d’attention sont également des fonctionnalités clés de ChatGPT. Si le vecteur d’intégration donne un sens au mot, les têtes d’attention permettent à ChatGPT de rassembler les mots et de continuer le texte de manière raisonnable. Les chefs d’attention examinent chacun les blocs de séquences vectorielles incorporées écrits jusqu’à présent. Pour chaque bloc de vecteurs intégrés, il les pondère ou les « transforme » en un nouveau vecteur qui passe ensuite à travers la couche de réseau neuronal entièrement connectée. Il le fait en continu tout au long de la séquence de texte à mesure que de nouveaux textes sont ajoutés.

La transformation de la tête de l’attention est une façon de revenir sur les séquences de mots jusqu’à présent. Il reconditionne la chaîne de texte précédente afin que ChatGPT puisse anticiper le nouveau texte qui pourrait être ajouté. C’est une manière pour ChatGPT de savoir par exemple qu’un verbe et un adjectif apparus ou qui apparaîtront après une séquence modifient le nom quelques mots plus tôt.

La meilleure chose à propos de ChatGPT est sa capacité à _________

| Très probable Mot suivant |

Chance |

| Apprendre | 4,5% |

| prévoir | 3,5% |

| Faire | 3,2% |

| comprendre | 3,1% |

| Faire | 2,9% |

Une fois que la collection originale de vecteurs intégrés a dépassé les blocs d’attention, ChatGPT collecte la dernière collection de transformations et la décode pour produire une liste de probabilité du jeton qui devrait venir ensuite. Une fois qu’un jeton est choisi dans la séquence de texte, l’ensemble du processus se répète.

Ainsi, ChatGPT a découvert un semblant de structure dans le langage humain, bien que de manière statistique. Est-ce qu’il reproduit algorithmiquement le langage humain systématique ? Du tout. Pourtant, les résultats Je suis surprenant et extraordinairement similaire au langage humain, et on se demande s’il est possible de reproduire algorithmiquement la structure systématique du langage humain.

Dans le prochain volet de cette série, nous explorerons les limites et les risques potentiels de ChatGPT et d’autres LLM et comment ils pourraient être atténués.

Si vous avez aimé cet article, n’oubliez pas de vous abonner Investisseur entreprenant.

Tous les messages représentent l’opinion de l’auteur. En tant que tels, ils ne doivent pas être interprétés comme des conseils en investissement et les opinions exprimées ne reflètent pas nécessairement celles du CFA Institute ou de l’employeur de l’auteur.

Crédit image : ©Getty Images /Yuichiro Chino

Formation professionnelle pour les membres du CFA Institute

Les membres du CFA Institute sont habilités à déterminer eux-mêmes et à déclarer eux-mêmes les crédits d’apprentissage professionnel (PL) acquis, y compris le contenu sur Investisseur entreprenant. Les membres peuvent facilement enregistrer des crédits en utilisant les leurs Localisateur PL en ligne.